hadoop基础命令,hadoop基础操作

作者:admin 发布时间:2024-11-04 22:42 分类:资讯 浏览:1 评论:0

今天给各位分享hadoop基础命令的知识,其中也会对hadoop基础操作进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

如何配置Hadoop环境

1、搭建Hadoop大数据平台的主要步骤包括:环境准备、Hadoop安装与配置、集群设置、测试与验证。环境准备 在搭建Hadoop大数据平台之前,首先需要准备相应的硬件和软件环境。

2、选择“Java Build Path” —— “Libraries” —— Add External Jars 到上面的画面后,下面就是选择开发hadoop程序时,用到的一些jar包 将lib文件夹下的所有的jar包,添加进去;将红框内的jar包,安装进去。

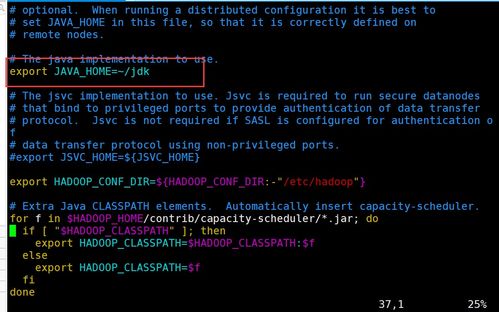

3、安装 Java 运行环境(JRE)或 Java 开发工具包(JDK)。Hadoop 是使用 Java 语言开发的,因此需要安装 Java 运行环境才能运行。配置 Java 环境变量。

hadoop中datanode怎么启动

1、首先,哪些服务器作为datanode,是根据你的hadoop的安装目录/etc/conf/slaves配置的主机的别名来决定的。其次,在第一次启动Hadoop前,必须先将HDFS格式化。使用hadoop namenode -format命令来格式化。

2、重启坏掉的DataNode或JobTracker。当Hadoop集群的某单个节点出现问题时,一般不必重启整个系统,只须重启这个节点,它会自动连入整个集群。

3、通过ssh命令让其他节点上的进程启动的呀,还记得用haoop要配置ssh无密码访问吗,就是干这个用的。

hadoop分布式每次都要重新启动吗

配置hosts文件,将主机名和对应IP地址映射。如图中Master、Slave1和Slave2是我们要搭建分布式环境的机器。Master为主机,Slavex为从机。

Hadoop初始化取决于你是如何使用Hadoop的,并不是每次都要初始化的。如果你是在本地模式下运行Hadoop,那么每次都需要初始化Hadoop环境,包括配置文件、目录结构、启动脚本等。

不是。不是每次启动集群时都要初始化的,首次启动集群时,必须进行格式化初始化操作,format操作,只能操作一次,在启动集群环境前。

如何查看hadoop集群是否安装成功(用jps命令

http://localhost:50070(HDFS的页面)如果都能查看,说明安装成功。一: 查看HDFS是否正常启动。在浏览器中输入http://localhost:50070 此页面为Hadoop HDFS管理的界面。点击Live Nodes 进入下图。上图表示,活动的节点为1个。

这说明你没有配置成功。jsp:是查看当前系统中用java的进程,没有即没成功。

运行jps没有显示,应该是没有配置好系统的path、java_home和classpath。执行hadoop fs -ls等同于hadoop fs -ls .该命令查看的是hdfs的/user/hadoop目录。而且默认是没有这个目录的。需要自己创建。

“hadoop@localhosts password:”ssh互信没有建立起来。执行 ssh-keygen -t dsa出现提示都回车就行。cd ~/.ssh cat id_dsa.pub authorized_keys 然后ssh localhost如果不需要密码就是设置成功了。

成功的截图如下:3 使用jps命令查看进程信息:若出现如图所示结果,则说明DataNode和NameNode都已经开启。

关于hadoop基础命令和hadoop基础操作的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接