hadoop的shell命令,hadoop常用的linux命令

作者:admin 发布时间:2024-11-06 12:22 分类:资讯 浏览:1 评论:0

本篇文章给大家谈谈hadoop的shell命令,以及hadoop常用的linux命令对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

hadoop怎么查看每个目录的路径

此时有个问题就是 NameNode 会将 HDFS 的元数据存储在这个/tmp目录下,如果操作系统重启了,系统会清空 /tmp 目录下的东西,导致NameNode元数据丢失,是个非常严重的问题,所有我们应该修改这个路径。

点击【Browse】,选择Hadoop文件夹的路径。点击【OK】后,出现Map/Reduce Locations选项卡。出现Map/Reduce Locations选项卡,如下图所示。最后就可以在Project Explorer中展开DFS的目录查看了,如图所示。

在浏览器中查看hdfs运行状态,网址:http://node1:50070 ()停止Hadoop。

求教如何用shell获取hadoop命令的执行返回值

1、CAT命令在用户主目录下创建一名为f1的文本文件,内容:Linux is useful for us all.You can never imagine how great it is。向文件f1增加以下内容:Why not have a try?。

2、shell脚本中判断上一个命令是否执行成功shell中使用符号“$?”来显示上一条命令执行的返回值,如果为0则代表执行成功,其他表示失败。结合if-else语句实现判断上一个命令是否执行成功。

3、在本教程中,我们将重点介绍如何通过hdfs dfs来高效地管理HDFS。

4、在UNIX/Linux下面编写一个 SHELL 脚本程序并不难,只要全屏幕编辑程序 vi 使用得熟练,即可以编写 SHELL 脚本程序。

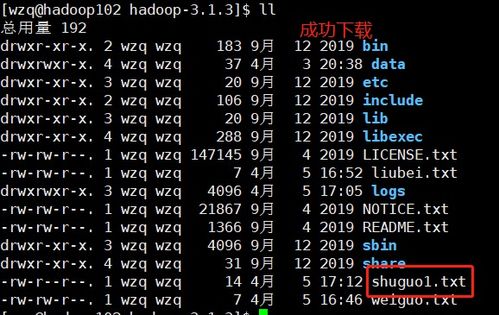

5、命令格式:hadoop dfs put filename newfilename 从本地文件系统中复制单个或多个源路径到目标文件系统。也支持从 标准输入 中读取输入写入目标文件系统。 采用-ls命令列出HDFS上的文件。

hadoop常用shell命令怎么用

1、使用方法:hadoop fs -copyFromLocal localsrc URI除了限定源路径是一个本地文件外,和put命令相似。copyToLocal使用方法:hadoop fs -copyToLocal [-ignorecrc] [-crc] URI localdst除了限定目标路径是一个本地文件外,和get命令类似。

2、bin=`cd$bin; pwd`,切换到start-all.sh的所在目录下,并将路径赋值给bin。DEFAULT_LIBEXEC_DIR=$bin/../libexec,获取${HADOOP_HOME}/libexec的绝对路径以备后用。

3、hadoop查看每个目录的路径需要验证数据。点击shell命令,hadoopfscountq目录ps,查看目录下总的大小。dfscount目录ps,一样的,hadoopfsdu目录ps,查看目录下每个子目录的路径。

4、安装Hadoop ()获取Hadoop压缩包hadoop-0.tar.gz,下载后可以使用VMWare Tools通过共享文件夹,或者使用Xftp工具传到node1。

关于hadoop的shell命令和hadoop常用的linux命令的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接