hadoop的常用命令,hadoophive命令大全

作者:admin 发布时间:2024-11-10 15:04 分类:资讯 浏览:1 评论:0

本篇文章给大家谈谈hadoop的常用命令,以及hadoophive命令大全对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、hadoop中命令经常含有-fs,-dfs,fs和dfs有什么区别?作用是什么?_百度...

- 2、如何配置Hadoop环境

- 3、搭建hadoop集群,常用配置文件是什么,以及配置哪些属性

- 4、HDFS文件

- 5、Hive的几种常见的数据导入方式

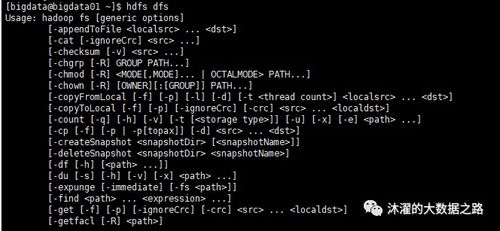

hadoop中命令经常含有-fs,-dfs,fs和dfs有什么区别?作用是什么?_百度...

hadoop fs:使用面最广,可以操作任何文件系统。hadoop dfs与hdfs dfs:只能操作HDFS文件系统相关(包括与Local FS间的操作),前者已经Deprecated,一般使用后者。

hadoop fs是一个通用的命令,适用于任何文件系统,无论是本地还是HDFS,它让你能够跨越多个环境进行操作。然而,hadoop dfs和hdfs dfs这两个命令专为HDFS设计,它们在功能上并无显著差异,都用于HDFS文件操作。

文件与目录管理 首先,使用hadoop fs –ls查看目录内容,例如:hadoop fs –ls /user/wangwu,能清晰展示指定路径下的文件和子目录。

命令格式:hadoop dfs put filename newfilename 从本地文件系统中复制单个或多个源路径到目标文件系统。也支持从 标准输入 中读取输入写入目标文件系统。 采用-ls命令列出HDFS上的文件。

FS是周期性信号的变换,中文名为傅里叶级数,有两种形式,指数型的和三角函数型的,本质一样。FT是非周期信号的变换,中文名为傅里叶变换。其实傅里叶变换是由傅里叶级数引申而来的。

fs.default.name属性用于定义HDFS的名称节点和其默认的文件系统,其值是一个URI,即NameNode的RPC服务器监听的地址(可以是主机名)和端口(默认为8020)。其默认值为file:///,即本地文件系统。

如何配置Hadoop环境

搭建Hadoop大数据平台的主要步骤包括:环境准备、Hadoop安装与配置、集群设置、测试与验证。环境准备 在搭建Hadoop大数据平台之前,首先需要准备相应的硬件和软件环境。

安装 Java 运行环境(JRE)或 Java 开发工具包(JDK)。Hadoop 是使用 Java 语言开发的,因此需要安装 Java 运行环境才能运行。配置 Java 环境变量。

. core-site.xml 配置:其中的hadoop.tmp.dir的路径可以根据自己的习惯进行设置。

搭建hadoop集群,常用配置文件是什么,以及配置哪些属性

1、准备基础环境:- 安装并配置JDK。- 配置/etc/hosts文件,确保节点间能通过主机名相互访问。- 配置SSH无密码登录,以便在节点间执行命令。- 创建必要的文件目录,为Hadoop准备存储空间。

2、hadoop的配置文件均以XML文件进行配置,它有四个最常见的配置文件,分别为:core-site.xml文件主要用于配置通用属性。hdfs-site.xml文件用于配置Hdfs的属性。mapred-site.xml文件用于配置Mapreduce的属性。

3、这次我配置的hadoop的版本是hadoop-2 。配置一点几的版本基本上都差不多。注意,配置hadoop在一台机器上配置好整个hadoop目录的内容,之后只需要将hadoop整个文件夹scp到其他的机器就可以了。

4、core-site.xml文件主要配置: NameNode的地址 通过fs.default.name属性配置NameNode的地址,Hadoop会根据该地址找到NameNode。

5、在安装过程中,还需要根据实际需求修改Hadoop的配置文件,如`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`等,以定义Hadoop集群的基本属性和行为。集群设置 在安装和配置好Hadoop之后,需要设置集群。

6、是的,Hadoop搭建过程中设置元数据文件存储路径的配置文件是hdfs-site.xml。在Hadoop集群中,元数据指的是HDFS(Hadoop Distributed File System)存储的文件系统命名空间和其他相关信息,例如文件副本的位置和块的位置等。

HDFS文件

1、HDFS适合存储大量的小文件是错误的。HDFS的全称是Hadoop Distributed File System,即Hadoop分布式文件系统。HDFS可将多台机器组合在一起进行数据存储,具有整体存储的能力。

2、查看HDFS文件的命令是`hdfs dfs -ls`。该命令用于列出指定路径下的文件和目录的详细信息。

3、HDFS是分布式文件系统技术框架。HDFS是Hadoop分布式文件系统,是Apache Hadoop的核心组件之一。它是一个高度容错性的系统,能够被设计成在商用硬件上运行以处理非结构化数据。

4、是的,HDFS(Hadoop Distributed File System)不支持多个Writers同时写入同一个文件。

5、HDFS(Hadoop分布式文件系统)是一种分布式文件系统,它主要用于存储大量的数据,并提供高可靠性和高吞吐量的数据访问。因此,HDFS是能够真正存储数据的分布式文件系统。

6、特别的,HDFS文件系统的操作可以使用 FsSystem shell 、客户端(http rest api、Java api、C api等)。

Hive的几种常见的数据导入方式

1、从本地文件系统中导入数据到Hive表;从HDFS上导入数据到Hive表;在创建表的时候通过从别的表中查询出相应的记录并插入到所创建的表中。

2、将json以字符串的方式整个入Hive表,然后使用LATERAL VIEW json_tuple的方法,获取所需要的列名。将json拆成各个字段,入Hive表。

3、直接使用hadoop fs -put命令把数据上传到HDFS上,然后在Hive中建表映射即可。或者使用LOAD DATA命令从本地加载数据到Hive表。你可以百度搜索lxw的大数据田地,查看[一起学Hive]系列文章。

4、terminated by ‘,’),所以不能直接将excel表格中数据导入的hive仓库中。处理方式如下:先将excel表中数据另存转化为data.csv格式,转化为.csv格式的文件默认就是用“,”进行分割的,可以用notepad++打开data.csv格式查看。

5、Solution 1 : 将json格式数据导入到MongoDB中,然后MongoDB可以将数据转换为CSV格式数据,然后导入到mysql中;CSSer.com采用的是wordpress程序,数据库为mysql,要想移植到MongoDB数据库,则需要进行数据转换。

6、今天我们再谈谈Hive中的三种不同的数据导出方式。根据导出的地方不一样,将这些方式分为三种:(1)、导出到本地文件系统;(2)、导出到HDFS中;(3)、导出到Hive的另一个表中。

关于hadoop的常用命令和hadoophive命令大全的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接