hbase命令批量导入数据,hbase 批量写入

作者:admin 发布时间:2024-06-10 22:16 分类:资讯 浏览:7 评论:0

今天给各位分享hbase命令批量导入数据的知识,其中也会对hbase 批量写入进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

向hbase中导入数据出错怎么办

检测这种类型的故障,需要利用MIB变量浏览器这种工具,从路由器MIB变量中读出有关的数据,通常情况下网络管理系统有专门的管理进程不断地检测路由器的关键数据,并及时给出报警。

网络问题。如果存储了数据但是在用hbase运行查询不到是因为网络问题,更换网络,重新启动即可。

通过读取HDFS上Region目录下的.regioninfo文件得到Region信息,同时读取hbase:meta表中的Region信息,得到两者的差集,就是需要修复的Region信息。然后将需要修复的Region信息写入到hbase:meta中。

ZooKeeper内存分配不足,尤其是大量数据导入的时候 其他程序存在内存溢出bug CPU消耗过大 节点失效timeout阈值过短 经过逐步排查,我们定位故障原因为第4点,timeout阈值不足。

数据入hbase不报错,客户端查不到数据 是因为:系统bug,使用软件hbase写代码时,当代码写入成功却查不出来,是系统bug的问题,将代码重新运行即可,HBase是一个分布式的。

办法是删除.META.中对应表项。原来,.META.和-ROOT-其实也是hbase的两个特殊的表,这就是说,我们可以scan、delete等对其进行操作。 scan ‘.META.可以看到,本来已经删除的表,还在这里存在记录。

六、HBase写入流程

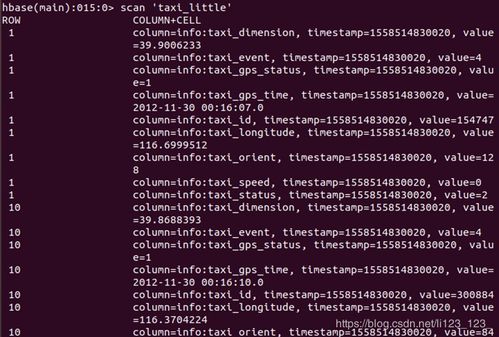

整个写入顺序图流程如下:1 客户端查找对应region 客户端根据要操作rowkey,查找rowkey对应的region。查找region的过程为通过zk获取到hbase:meta表所在region。

对于写操作,HBase提供了Put操作。一个Put操作就是一次写操作,它将指定Row Key的数据写入到HBase中。

首先Hbase是依赖于HDFS和zookeeper的。 Zookeeper分担了Hmaster的一部分功能,客户端进行DML语句的时候,都是先跟ZK交互。

和读相比,HBase写数据流程倒是显得很简单:数据先顺序写入HLog,再写入对应的缓存Memstore,当Memstore中数据大小达到一定阈值(128M)之后,系统会异步将Memstore中数据flush到HDFS形成小文件。

hbase导入重复数据能覆盖吗

必须在设计上保证RowKey的唯一性。由于在HBase中数据存储是Key-Value形式,若向HBase中同一张表插入相同RowKey的数据,则原先存在的数据会被新的数据覆盖。设计的RowKey应均匀的分布在各个HBase节点上,避免数据热点现象。

由于在HBase中数据存储是Key-Value形式,若向HBase中同一张表插入相同RowKey的数据,则原先存在的数据会被新的数据覆盖。设计的RowKey应均匀的分布在各个HBase节点上, 避免数据热点现象。

高可靠性 HBase采用了数据冗余和自动故障恢复的机制,可以保证数据的高可靠性。它将数据副本存储在不同的服务器上,并在主节点故障时自动切换到备用节点,确保数据的持久性和可用性。

数据模型:HBase采用列式存储模型,数据被组织成行和列的形式,每一行都有一个唯一的行键来标识。行键是按照字典顺序排序的,方便进行范围查询。每个列族包含一系列列,列被动态定义,可以根据实际需要灵活增减。

由于HBase位于Hadoop框架之上,因此可以使用HadoopMapRece来快速、高效地生成索引表。数据维护。在关系数据库中,更新操作会用最新的当前值去替换记录中原来的旧值,旧值被覆盖后就不会存在。

hbase导入导出方式有哪些

1、导入:hadoop jar /../hbase/hbase-.jar import mytest /export/mybakup 导出:hadoop jar /../hbase/hbase-.jar import mytest /import/mybackup 直接将数据导出到hdfs目录中,当不指定file前缀时。

2、尽管importtsv 工具在需要将文本数据导入HBase的时候十分有用,但是有一些情况,比如导入其他格式的数据,你会希望使用编程来生成数据,而MapReduce是处理海量数据最有效的方式。这可能也是HBase中加载海量数据唯一最可行的方法了。

3、所以我们只能自己来写一个MR了,编写一个Hbase的MR,官方文档上也有相应的例子。我们用来加以化妆就得到我们想要的了。

4、如何使用JAVA语言操作Hbase、整合Hbase? 可分为五步骤:步骤1:新创建一个Java Project 。 步骤2:导入JAR包,在工程根目录下新建一个“lib”文件夹,将官方文档中的lib目录下的jar全部导入。

5、使用 Hcatalog 进行导入 将 orc 格式的 Hive 表格导入到关系型数据库中 本文介绍了使用腾讯云 Sqoop 服务将数据在 MySQL 和 Hive 之间相互导入导出的方法。 开发准备 确认已开通腾讯云,并且创建了一个 EMR 集群。

6、Eclipse中执行Hbase程序需要导入的jar包如下Hadoop全部jar包Hbase部分jar包Hbasejar包不能多也不能少。多了会冲突。

hbase(分布式、可扩展的NoSQL数据库)

1、HBase是一种分布式、可扩展的NoSQL数据库,它是基于Hadoop的HDFS文件系统构建的。HBase被设计用来处理海量数据,并提供高可靠性、高性能的读写操作。

2、HBase是一个基于Apache Hadoop的面向列的NoSQL数据库,是Google BigTable的开源实现。它运行在HDFS之上,为Hadoop提供类似于BigTable规模的服务。

3、深入了解 HBase:NoSQL 数据库的魅力与核心原理HBase,这个强大的分布式 NoSQL 数据库,凭借其在大数据存储、高并发写入和实时查询方面的卓越性能,成为数据处理领域的热门选择。

4、数据存储方式不同、适用场景不同。HBase是一种分布式、面向列的NoSQL数据库,而传统数据库通常是基于关系模型的关系型数据库。这两种数据库在数据存储方式上有所区别。

hbase命令批量导入数据的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于hbase 批量写入、hbase命令批量导入数据的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

- 上一篇:天正命令框变大命令,天正t20命令栏

- 下一篇:month命令,命令mount

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接