hdfs命令操作,hdfs命令操作总结反思

作者:admin 发布时间:2024-06-21 05:00 分类:资讯 浏览:11 评论:0

本篇文章给大家谈谈hdfs命令操作,以及hdfs命令操作总结反思对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

- 1、HDFS中根目录下创建user文件夹的命令为

- 2、怎样进入hdfs的shell命令行

- 3、HDFS和本地文件系统文件互导

- 4、启动hadoop的命令行

- 5、怎么用命令行删除hdfs上的文件

- 6、hadoop常用shell命令怎么用

HDFS中根目录下创建user文件夹的命令为

1、hdfsshell命令使用最广的是以下几种:ls:列出指定路径下的文件和目录。示例:hdfsdfs-ls/path/to/dir.mkdir:创建新的目录。示例:hdfsdfs-mkdir/path/to/newdir。put:将本地文件复制到HDFS中。

2、从fs -ls从列出来的文件看,这个文件夹/user/root/input是通过root用户创建的。

3、HDFS支持传统的分层文件管理,用户或者应用能够在目录下创建目录或者文件。文件系统命名空间和其他文件系统是相似的,支持创建、删除、移动和重命名文件。HDFS支持用户数量限制和访问权限控制,不支持软硬链接,用户可以自己实现软硬链接。

4、然后在分布式文件系统(hdfs)中新建一个test文件夹,用于上传我们的测试文件haha.txt。

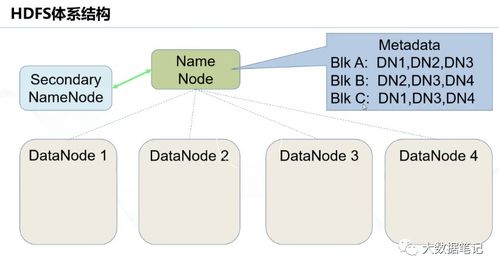

5、NameNode 是所有HDFS 元数据的仲裁和仓库。系统设计上,用户数据永远不经过NameNode。 HDFS 支持传统的文件分级组织。用户或应用可以创建目录,并在目录内存储文件。

怎样进入hdfs的shell命令行

启动hadoop的命令行:start-all.sh 启动所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrack。start-dfs.sh 启动Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNode。

命令格式:hadoop dfs put filename newfilename 从本地文件系统中复制单个或多个源路径到目标文件系统。也支持从 标准输入 中读取输入写入目标文件系统。 采用-ls命令列出HDFS上的文件。

连接上相应的linux主机,进入到等待输入shell指令的linux命令行状态下。在linux命令行下输入shell指令:vi test.shell。最后,按下回车键执行shell指令,此时发现用vi命令成功进入了shell编程模式中。

向hdfs上传文件正确的shell命令是hdfsdfs-put。根据相关公开信息查询显示:向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,由用户指定是追加到原有文件末尾还是覆盖原有的文件。

在开始Shell编程之前,我们需要设置好开发环境。首先,我们需要打开终端窗口,这可以通过在桌面上单击终端图标或使用快捷键Ctrl+Alt+T来实现。

shell_scripts进入步骤如下:连接上相应的主机,进入到等待输入shell_scripts指令的linux命令行状态下。在linux命令行下输入shell指令:vitest.shell。最后,按下回车键执行shell_scripts指令。

HDFS和本地文件系统文件互导

导入 ./hbase org.apache.hadoop.hbase.mapreduce.Driver import 表名 数据文件位置 其中数据文件位置可为本地文件目录,也可以分布式文件系统hdfs的路径。

从本地文件系统中复制单个或多个源路径到目标文件系统。也支持从 标准输入 中读取输入写入目标文件系统。 采用-ls命令列出HDFS上的文件。在HDFS中未带参数的-ls命令没有返回任何值,它默认返回HDFS的home目录下 的内容。

从本地文件系统中导入数据到Hive表;从HDFS上导入数据到Hive表;在创建表的时候通过从别的表中查询出相应的记录并插入到所创建的表中。

启动hadoop的命令行

1、启动hadoop的命令是:`start-dfs.sh` 和 `start-yarn.sh`。这两个命令分别用于启动Hadoop分布式文件系统(HDFS)和Hadoop资源管理器(YARN)。要启动Hadoop,请按照以下步骤操作:打开终端或命令提示符窗口。

2、bin/hadoop namenode -format 在分配的NameNode上,运行下面的命令启动HDFS:bin/start-dfs.sh bin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

3、Hadoop集群启动命令。启动NameNode,DataNode。启动JournalNode,JournalNode在hdfs-site.xml中指定editslog存储的位置,主备NameNode共享数据,方便同步。3)、启动DFSZKFailoverController,HA会启用ZooKeeperFailoverController。

4、Hadoop的命令位于${HADOOP_HOME}/bin、${HADOOP_HOME}/sbin、${HADOOP_HOME}/libexec下面。包含了Linux的shell脚本和windows的批处理文件。本文主要解析linux下的shell脚本。

怎么用命令行删除hdfs上的文件

命令:hadoop fs -rmr /home/mm/lily2(要求是你把hadoop的bin加到PATH中,并开启hadoop)rm -rf /home/mm/lily2(这是删除linux文件系统的文件夹)。

删除文件:可以使用以下命令将文件从HDFS中删除:hadoop fs -rm /path/to/0filename 在任何情况下,都应该避免创建文件名以0或1开头的文件,以避免这种问题的出现。

通过“-get 文件按1 文件2”命令将HDFS中某目录下的文件复制到本地系统的某文件中,并对该文件重新命名。

hadoop常用shell命令怎么用

1、使用方法:hadoop fs -copyFromLocal localsrc URI除了限定源路径是一个本地文件外,和put命令相似。copyToLocal使用方法:hadoop fs -copyToLocal [-ignorecrc] [-crc] URI localdst除了限定目标路径是一个本地文件外,和get命令类似。

2、bin=`cd$bin; pwd`,切换到start-all.sh的所在目录下,并将路径赋值给bin。DEFAULT_LIBEXEC_DIR=$bin/../libexec,获取${HADOOP_HOME}/libexec的绝对路径以备后用。

3、hadoop查看每个目录的路径需要验证数据。点击shell命令,hadoopfscountq目录ps,查看目录下总的大小。dfscount目录ps,一样的,hadoopfsdu目录ps,查看目录下每个子目录的路径。

4、SSH设置需要在集群上做不同的操作,如启动,停止,分布式守护shell操作。认证不同的Hadoop用户,需要一种用于Hadoop用户提供的公钥/私钥对,并用不同的用户共享。下面的命令用于生成使用SSH键值对。

5、常见的在伪分布式环境下使用的Shell命令包括:start-dfs.sh启动分布式文件系统、start-yarn.sh启动资源管理器、hadoop fs操作分布式文件系统、hadoop jar运行Hadoop任务等。

hdfs命令操作的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于hdfs命令操作总结反思、hdfs命令操作的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

- 上一篇:esym命令,elev命令

- 下一篇:batch命令读法,bat命令

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接