hdfs检查命令,hdfs查看

作者:admin 发布时间:2024-10-04 18:54 分类:资讯 浏览:2 评论:0

本篇文章给大家谈谈hdfs检查命令,以及hdfs查看对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

HDFS常用命令

1、输入命令: [hduser@node1 ~]$ cd ~/hadoop [hduser@node1 hadoop]$ bin/hdfs namenode –format (2)关闭node1,node2 ,node3,系统防火墙并重启虚拟机。

2、HDFS PUT命令 这个在前面你应该已经使用过了。put命令在实际环境中也比较常用,通常配合shell、python等脚本语言来使用。建议熟练掌握。 2 HDFS API HDFS提供了写数据的API,自己用编程语言将数据写入HDFS,put命令本身也是使用API。

3、初始化HDFS系统 在hadop1目录下执行命令:bin/hdfs namenode -format 出现如下结果说明初始化成功。

hadoop常用shell命令怎么用

1、{XXX}这些都是配置的环境变量,可以是基于用户的(比如用户根目录下的.bashrc文件)也可以是root权限的(root用户根目录下的.profile文件)-input,-output这是都是执行hadoop命令的参数。

2、前面已经有篇文章介绍如何编译包含hive的spark-assembly.jar了,不清楚的可以翻看一下前面的文章。

3、完成Hadoop的安装以后,再安装Spark(Local模式)。使用hadoop用户名登录进入Linux系统,启动Hadoop,参照相关Hadoop书籍或网络资料,或者也可以参考本教程官网的“实验指南”栏目的“HDFS操作常用Shell命令”。

4、连接上相应的linux主机,进入到等待输入shell指令的linux命令行状态下。在linux命令行下输入shell指令:ll。最后,按下回车键执行shell指令,此时会看到所有用户所属文件夹的rwx权限信息。

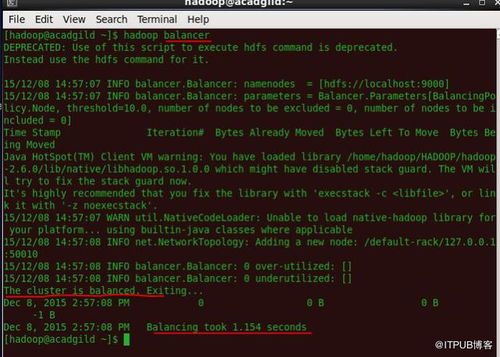

如何用命令确认hadoop集群的健康状况

1、要解决此问题,你可以采取以下步骤: 检查目标节点服务是否已经启动,可以使用如下命令确认服务状态:`sudo systemctl status `,其中 `` 是具体的服务名称,例如:`hadoop-hdfs-datanode`。

2、请注意,在启动Hadoop之前,请确保您已经安装了Java运行时环境(JRE)和Hadoop二进制文件。另外,如果您正在使用集群,则需要配置适当的启动脚本以在启动Hadoop时自动运行所有必需的服务。

3、结果报错:解决方法 hadoop fs -ls 命令的完整语法是:hadoop fs -ls [path]默认情况下当你未指定[path] 时,hadoop会在HDFS里面将路径扩展为/home/[username];这样的话[username]就会被执行命令的Linux用户名替代。

怎样用shell命令查看hdfs上是否存在某个文件

了解你的意思,首先,test命令是判断某一个特定的文件相关信息,也就是当你使用test这个命令的时候,你是清楚它叫什么名字的(只是你不知道它的相关信息)。

Shell中的test命令用于检查某个条件是否成立,它可以进行数值、字符和文件三个方面的测试,那么如何使用shell来判断文件夹是否存在呢?今天小编就就带大家来看看吧。

如果你用wget等命令行下载那么默认是运行该程序的当前目录。如果用浏览器可以查看设置,里面有默认的下载目录,一般在桌面。

find命令 (1)find是linux下用于查找文件的通用方法。

该表判断方法如下:在Shell中,可以使用以下命令来判断Hadoop表是否为分区表:shell hadoop fs-ls 是Hadoop表在HDFS上的路径。例如“/user/hive/warehouse/my_table”。执行此命令后,会列出表的所有文件和目录。

tar命令 为文件和目录创建档案语法:tar [主选项+辅助选项] 文件或者目录 : u 主选项-c 创建新的档案文件。

关于hdfs检查命令和hdfs查看的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

本文章内容与图片均来自网络收集,如有侵权联系删除。

- 上一篇:高级cmd命令,cmd命令基础教学

- 下一篇:msg命令手机,msg指令

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接