kafka命令,kafka启动kafka命令

作者:admin 发布时间:2024-10-17 00:51 分类:资讯 浏览:2 评论:0

今天给各位分享kafka命令的知识,其中也会对kafka启动kafka命令进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

- 1、关于kafka消费者的命令

- 2、kafka消费者状态检查—消费的offset是否滞后/堆积

- 3、如何使用命令查看kaf

- 4、在服务器里怎么查看kafka创建了哪些主题

- 5、Kafka:如何高效运维之主题篇

关于kafka消费者的命令

sh kafka-consumer-groups.sh --bootstrap-server ip:端口,ip:端口,ip:端口 --group 订阅组 --describe 我在本地idea起了两个进程 那么CONSUMER-ID会有两个,但是CLIENT-ID依旧是一个。

第四条消息:生产更多的消息:查看myConsumerGroup,看到多了一个CONSUMER-ID. 说明这个消费者组中有2个消费者。查看消费者组信息。

默认的线程池是什么?执行:ListenerConsumer实现了Runnable,所以最终由run方法调用的poll()来拉取消息。

kafka消费者状态检查—消费的offset是否滞后/堆积

1、简单来说,如果partition里已经有数据,但还没有消费,earliest就会从没消费的起始点来消费,反观latest就不会去消费;如果partition已经有已消费的数据,再放新的数据进去,那么它们都会从新的数据开始消费。

2、要实现这个功能,就需要知道上次消费时的消费位移,消费者在消费完消息后要进行消费位移提交动作,且消费位移要进行持久化,消费位移保存在__consumer_offsets主题中。

3、consumer消费了5条消息,那么offset就是5,指向了下一条要消费的记录,consumer 需要向kafka汇报自己的位移数据,因为consumer是能够消费多个分区的,所以offset 的粒度是分区,consumer需要为分配给他的各分区分别提交offset信息。

4、消费offset与生产offset之间的差值、当前消费topic-partition的group成员id(不一定包含hostname)上面示例中console-consumer-11967是为了测试临时起的一个console consumer,缺少在zookeeper中保存的current_offset信息。

5、当前消费者需要提交的消费位移是offset+1 在旧消费者客户端中,消费位移是存储在 ZooKeeper 中的。而在新消费者客户端中,消费位移存储在 Kafka 内部的主题__consumer_offsets 中。

如何使用命令查看kaf

1、命令行直接输入:iptraf(如果没有,使用yum install iptraf安装)打开进入选择ip镜像。 选择监听测试的接口,所有接口。开启监听状态日志,系统默认日志路径。

2、我的:linux查看本机IP的命令是:ipa 一般还可以使用ifconfig-a命令查看 或者是hostname-I也是可以的。

3、使用命令”df -l和df -h“具体查看分区使用状况。实际这两个命令具有一样的作用区别是显示的容量单位不一样,当然也可以直接使用明”df -lh“。

4、鼠标点击桌面左下角开始按钮2在输入框中输入CMD 3打开管理员系统窗口4在管理员系统窗口中输入ipconfigall,查询本机的IP地址5接下来进行ping IP了,输入ping ,回车后会显示出结果,如果。

5、在服务器上要查看一个硬盘的容量或者是大小,或者是剩余空间,都是没有桌面的,那么必须要用到命令查看的。

在服务器里怎么查看kafka创建了哪些主题

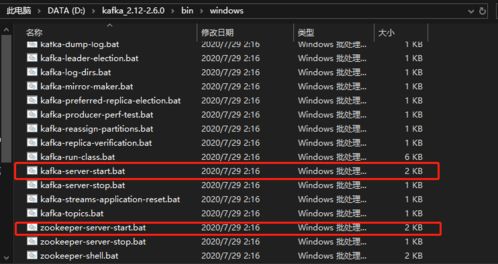

1、进入服务器后,找到kafka安装目录进入bin文件夹,输入命令--- 查看kafka现有主题命令:。

2、Kafka 提供了 kafka-topics 脚步用来创建、修改、删除、查询 topic,位于${kafka_home}/bin/kafka-topics.sh,其中 kafka_home 表示 Kafka 的安装目录。一些不那么直观的选项进行单独介绍。

3、主题(topic):一个 topic 里保存的是同一类消息,相当于对消息的分类,每个 producer 将消息发送到 kafka 中,都需要指明要存的 topic 是哪个,也就是指明这个消息属于哪一类。

Kafka:如何高效运维之主题篇

本文属于学习的第二阶段:[ 从运维实战的角度学习 Kafka ],重点学习 Kafka 的主题,通过运维命令创建、更新主题,从 Topic 的 可运维属性,了解 Topic 在 Kafka 内部的运作机制 。

在通常情况下,增加分区可以提供kafka集群的吞吐量。然而,也应该意识到集群的总分区数或是单台服务器上的分区数过多,会增加不可用及延迟的风险。

kafka的持久化在上面已经提到,kafka绕过了java的堆处理数据,直接将数据写入页缓存,然后由操作系统来管理页缓存写入磁盘,实现持久化。

Zookeeper 是 Kafka 代理和消费者之间的协调接口。Kafka 服务器通过 Zookeeper 集群共享信息。Kafka 在 Zookeeper 中存储基本元数据,例如关于主题,代理,消费者偏移(队列读取器)等的信息。

Kafka按照接收顺序对归集的信息进行缓存,并加入待消费队列。Kafka的consumer读取队列信息,并一定的处理策略,将获取的信息更新到数据库。完成数据到数据中心的存储。

之前讲到过,一个Topic主题中可以有多个Partition分区,并且每个分区都可以有多个副本,这是Kafka的一个数据冗余机制。

kafka命令的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于kafka启动kafka命令、kafka命令的信息别忘了在本站进行查找喔。

本文章内容与图片均来自网络收集,如有侵权联系删除。

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接